$NVDA just unveiled a version of its A100 server GPU that packs 80GB of HBM2e memory (twice as much as before).

— Eric Jhonsa (@EricJhonsa) November 16, 2020

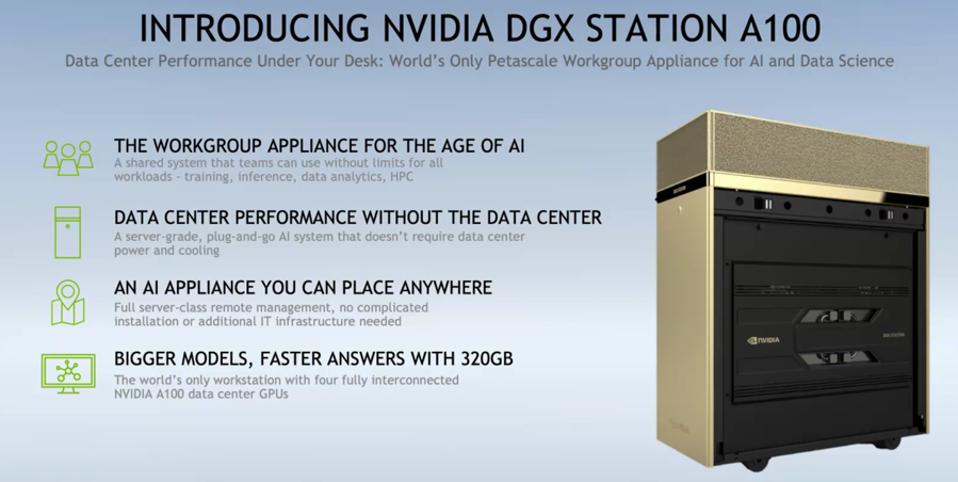

Also unveiled: A workgroup server containing 4 A100 GPUs and a 64-core $AMD Epyc CPU, and 400-gig Mellanox interconnect hardware.https://t.co/rEVgPu5jKn

Memory Bandwidthも2.0TB/secに向上しているという

— t3840 (@t3840) November 16, 2020

まーじやばい

NVIDIA Announces A100 80GB: Ampere Gets HBM2E Memory Upgrade https://t.co/eMgzPio9Xr pic.twitter.com/7LygZMRi7g

For some reason, @anandtech keeps forgetting about the A100 tensor cores. FP64 peak on A100 is 19.5 TFLOPs, not 9.7. Most compute bound FP64 applications can use small matrix multiplies very effectively.https://t.co/ECtIf6y1cj

— Bryan Catanzaro (@ctnzr) November 16, 2020

I think I should ask the boss for a new PC. It's only 199,000 dollars, should be a no-brainer. Wish me luck...https://t.co/l6Hv86C21f

— Buck Woody (@BuckWoodyMSFT) November 16, 2020

Nvidia, 개선 된 서버 GPU 및 새로운 Mellanox 하드웨어 공개 https://t.co/IHD1LDgLKb

— editoy (@editoy) November 17, 2020

AnandTech: NVIDIA Announces A100 80GB: Ampere Gets HBM2E Memory Upgradehttps://t.co/57pgiX8MG0

— RetiredEngineer® (@chiakokhua) November 16, 2020

When will gaming PCs look this good? Enough with the LED lighting. https://t.co/yQksvm1iED

— Matt Youngberg (@theironwrist) November 17, 2020

NVIDIA's latest desktop workstation has four 80GB GPUs https://t.co/EdVc5BGe0O #Tech pic.twitter.com/ADOEGV5bYS

— Reg Saddler (@zaibatsu) November 16, 2020

Tom's Hardware: AMD Announces the Instinct MI100 GPU, CDNA Breaks 10 TFLOPS Barrierhttps://t.co/OP9smdszDw

— RetiredEngineer® (@chiakokhua) November 16, 2020

$AMD, meanwhile, just took the wraps off its first CDNA server GPU (the MI100). 11.5/23.1 TFLOPS of FP64/FP32 performance, 32GB of HBM2 memory and a 300W TDP.https://t.co/nw6zTdht0C

— Eric Jhonsa (@EricJhonsa) November 16, 2020

.png)